Introducción a la programación paralela

Volver a Cursos

Introducción a la Computación Paralela - Código 28661

Carlos Jaime Barrios Hernandez, PhD. - (c b a r r i o s (@) u i s . e d u . c o )

Asistencia Técnica-Teórica:. Equipo SC3UIS y CAGE

Contents

- 1 PRESENTACION DEL CURSO

- 2 Contenido

- 3 Metodología - Curso Especial 2- 2020

- 4 Evaluación

- 5 Bibliografía y Fuentes de Información

- 6 PRESENTACIONES DEL CURSO

- 7 CONSULTA A ESTUDIANTES

PRESENTACION DEL CURSO

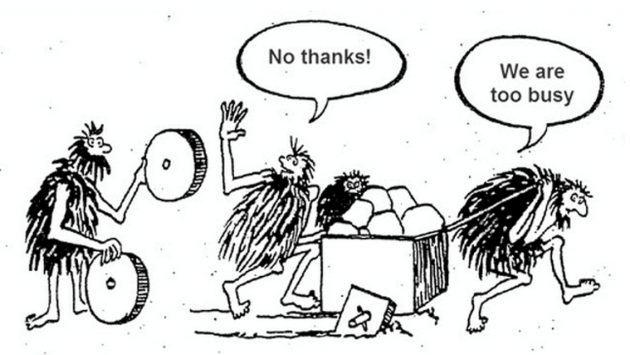

La ruptura tecnológica hace que la computación sea quizás el área del conocimiento más dinámico que existe y que no solo promueve tendencias sino también cambios sociales, desde que la información y su tratamiento no solo es una necesidad sino una exigencia. La computación paralela, si bien no es nada nuevo, como parte de esa "exigencia" permite la explotación de sistemas que desde hace más de treinta años están disponibles, pero que en algunos medios se ve aún como algo exótico, ignorando que gracias a esas posibilidades, desde poder escuchar música, hablar y tomar fotos de manera simultánea en un dispositivo móvil, pasando por pronosticar el clima o mercados, almacenar datos en la nube hasta la realidad de implementar soluciones y algoritmos de inteligencia artificial hoy, existe porque hay múltiples unidades de procesamiento que pueden ser programadas de manera paralela y concurrente.

El curso, que es para principiantes, esta dirigido a estudiantes de ingeniería de sistemas y ciencias de la computación, cuyo principal objetivo es ofrecer fundamentos para la explotación de la concurrencia, la explotación de paradigmas de programación dirigidos al paralelismo, sin ignorar algunos conceptos arquitecturales necesarios para entender que soporta ese procesamiento en paralelo. A partir de este curso, los participantes manejaran la terminología necesaria igualmente y tendrán la base para a partir de allí seguir cursos avanzados y seminarios especializados.

Contenido

- Introducción a la Computación Paralela

- Pensamiento Paralelo y Pervasibidad

- Elementos de Paralelismo

- Evolución de la Computación Paralela

- Computación de Alto Rendimiento (HPC)

- Arquitecturas Paralelas y Sistemas Escalables

- Modelos de Máquinas Paralelas

- Modelos de Ejecución Paralela

- Paralelismo y Comunicación

- Caracterización de Flynn

- Multinúcleos y Multiprocesamiento (multicores - multiprocessing)

- Procesamiento Vectorial

- Arquitecturas para el Procesamiento Masivamente Paralelo (Manycores)

- Modelos de Memoria

- Jerarquia de Memoria

- Sistemas Distribuidos de Gran Escala

- Unidades de Procesamiento Tensor

- Unidades de Procesamiento Cuántico

- Sistemas Operativos, Sistemas de Archivos, Calendarización y Monitoreo en Arquitecturas Paralelas

- Aspectos especiales de Linux y Slurm

- Top500 y Otros Rankings

- Algoritmos Concurrentes y Paralelos

- Caracterización de Paralelismo

- Granularidad

- Multihilos y Multiprocesos

- Modelos de Computación (RAM, PRAM, Sorting Networks, BSP, LogP y otros)

- Modelos de Algoritmos Concurrentes

- Descomposición de Tareas

- Descomposición de Datos

- Dividir y Conquistar

- Tuberias (Pipeline)

- Recursividad y Otros (Embarrassingly Parallelism y Otros)

- Algoritmos No Paralelos

- Balanceo de Carga y Calendarización (Scheduling)

- Paradigmas y Modelos de Programación Paralela

- Ambientes de Programación Paralela

- Modelo de Programación de Memoria Compartida

- OpenMP

- Modelo de Programación de Memoria Distribuída

- Paso de Mensajes con MPI

- Modelo Programación de Memoria Híbrida/Heterogénea

- Programación de Sistemas CPU-GPU (Sistemas GPGPU)

- Fundamentos de Programación de GPUs y Múltiples GPU con CUDA

- Programación de Sistemas CPU-GPU (Sistemas GPGPU)

- Uso de Directivas de Aceleración con OpenACC

- Otros Mecanismos de Implementación y Aceleración de Aplicaciones

- Optimización

- Optimización Local y Global Paralela

- Evaluación de Desempeño

- Latencia y Throughput

- Speedup (Aceleración), Eficiencia y Escalabilidad

- Ley de Amhdal

- Ley de Gustaffon-Barsis

- Complejidad Asimptótica (Aceleración y Eficiencia)

- Modelo de Little

- Análisis de Rendimiento y Tunning (Ajuste)

- Debugging and Profiling

- Consideraciones de Debugging y Monitoreo de Rendimiento y Comportamiento

- Herramientas para el Debugging y el Profling

- Lineamientos para el Desarrollo de Aplicaciones Paralelas

- Patrones para el Flujo de Control y de Ejecución

- Patrones para la Administración de Datos

- Espacios de Diseño y Desarrollo de Programas Paralelos

- Búsqueda de Explotación de Concurrencia

- Diseño de Estructura de Algoritmo

- Selección de Estructuras de Soporte de Algoritmos Paralelos

- Selección de Mecanismos de Implementación

- Direcciones y Tendencias en Programación Paralela

- HPC@Green: Eficiencia Computacional Hoy (Consumo Energético/Procesamiento)

- Explotación de Unidades Tensor y Aplicaciones Emergentes

- Extracción de Paralelismo en Códigos Secuenciales

- Explotación de Memoria

- Paradigmas de Programación Emergentes

Metodología - Curso Especial 2- 2020

Se realizarán sesiones teóricas via visioconferencia de manera sincrónica los dias martes de 10:05 a.m. a 11:55 y de manera sincrónica/semi-asincrónica laboratorios prácticos en la tarde de los dias martes. El acompañamiento e interacción se realizará a través de un foro para algunas de las prácticas que esta a disposición en este sitio.

Evaluación

Evaluaciones programadas para el 2do Semestre de 2020

Las evaluaciones programadas para este semestre, se detallarán en la sesión teórica, normalmente dos semanas antes de la fecha de entrega. Igualmente las prácticas serán informadas en la sesión teórica previa así como las fechas y horas limites de entrega. Las diferentes entregas que son individuales o en grupo de acuerdo se diga, se realizarán principalmente via github.

Evaluación 1 (25%) C/C++ Procesamiento Memoria Compartida (Individual):

Fecha Limite de Entrega: Sábado 28 de Noviembre de 2020 hasta las 23:59 (GMT - 5, Bogotá Time)

En esta primera entrega, dividida en cinco partes, tiene como objetivo evaluar las competencias adquiridas en torno a la transformación de códigos que se encuentran implementados en C/C++ para su ejecución paralela usando OpenMP. Cada uno de los estudiantes recibirá un correo electrónico personalizado que contendrá la descripción y encabezado del código recibido (en inglés principalmente), junto con el código respectivo (en .c). Este código se encuentra debidamente documentado y licenciado para su uso bajo una licencia GPL .

La metodología para realizar la evaluación y la entrega es la siguiente:

- Cree o reactive una cuenta existente en Github (puede usar cualquier nombre o pseudonimo), sin embargo tenga en cuenta que el github que usted cree es parte de sus evidencias de presentación profesional, que incluso se referencian hoy en dia en hojas de vida.

- Debe vincularse a Supercomputación y Cálculo Científico de la Universidad Industrial de Santander (SC3UIS) y dentro de SC3UIS, unirse al equipo beginners-hpc https://github.com/orgs/SC3UIS/teams/beginners-hpc

- Una vez asociados, deberán crear un repositorio (carpeta) de la siguiente manera: IntroPP<Código de Estudiante>, asi, si por ejemplo su código de estudiante es 941108, el repositorio será IntroPP941108.

- Dentro de ese repositorio crear un repositorio adicional que se llame OpenMP

- Es recomendable por cada nuevo repositorio que genere, crear un README explicando que contiene allí.

- Y en ese repositorio deberán subir los archivos relacionados con la entrega, que básicamente son (5) cinco:

- Archivo con el código original en C (se había dicho que no pero se decidió que si)

- Archivo con el nuevo código en OpenMP (que llamaran omp_<nombre_codigo_fuente_original>.c (Si el código fuente que recibieron por ejemplo se llama transform.c, el código nuevo que subirán allí se llamara omp_transform.c). Como es obvio el código fuente que recibirán es en C.

- Archivo sbatch para la corrida en GUANE-1 (BONUS). Igual si su código se llama omp_transform el sbatch se llamara transform.sbatch.

- Archivo Readme, en no mas de diez lineas deben explicar con sus palabras y en español que hace el código, deben muestrar las opciones de compilación y de corrida (pueden realizar la compilación en gcc o icc). En ese archivo deben colocar como se ejecuta en local (en sus maquinas) y como se ejecuta en GUANE-1.

- Archivo de salida que llamarán output_<nombre_codigo_openmp>.txt, entonces si su código se llama omp_transform.c su archivo de salida se llamara output_transform.txt

- Para el código recibido, deben realizar una versión en OpenMP de acuerdo a los fundamentos vistos en clase y los que consulten en la bibliografía relacionada. El nuevo código que realicen lo deben igualmente documentar, manteniendo el estilo de la documentación, por ejemplo:

/* Purpose: TRANSFORM is an example of a transformation of an EDP using some parameters for Intro PP Students. Example: 31 May 2001 09:45:54 AM Licensing: This code is distributed under the GNU LGPL license. Modified: 24 September 2003 Author: George OpenMP Modification: 27 July 2020 by Levy Rincon, Universidad Industrial de Santander levy.rincon@correouis.edu.co This OpenMP Modification makes a parallelization of the original Code... */

(Tengan en cuenta solo deben adicionar una sección de su modificaciones, explicando brevemente que es lo que hace, puede hacerlo en inglés (recomendado) o en español)

Nota importante: usted puede realizar modificaciones al código recibido originalmente, por supuesto debe explicar esas modificaciones y por qué las hace de acuerdo a la versión original. Puede subir el archivo original dado, pero no olvide colocar en los comentarios el autor y de donde fue seleccionado.

3. Como se dijo inicialmente y por eso se insiste, deben documentar en el cuerpo de su código fuente las variaciones que ustedes hagan. Pueden hacerlo en español (pero se recomienda tratar de hacerlo en inglés).

4. Los mismos (5) cinco archivos igualmente MAS EL ARCHIVO EJECUTABLE, con las mismas condiciones deben ser colocados dentro de su carpeta personal en la plataforma de SC3UIS y su cuenta asociada a GUANE-1 (ver el punto 1.), en otras palabras, cree una carpeta llamada OpenMP. En total son seis archivos en su repositorio en GUANE-1.

5. Finalmente deben enviar la dirección del enlace donde podrá verse su entrega al correo del profesor con copia a la cuenta de soporte de SC3UIS sc3.soporte(-@-)uis.edu.co hasta la fecha y hora limite escrita en el encabezado. En el cuerpo del correo deben colocar su código de estudiante, nombre completo y las indicaciones para acceder a su espacio en Github. Esto debe realizarlo únicamente desde el dia viernes 27 de noviembre de 2020, a cualquier hora. Recuerde nuevamente la fecha y hora límite: Sábado 28 de Noviembre de 2020 hasta las 23:59 (GMT - 5, Bogotá Time). SE RECOMIENDA ALTAMENTE SOLO ENVIAR EL CORREO EL MISMO SABADO.

Es posible que encuentren soluciones de los problemas dados ya implementadas en OpenMP (de hecho, todos los problemas tienen ya solución paralela), por lo que pueden usarla como guía (no solo se limiten a copiar y pegar), entender lo que hace ya paralelizado y deben enviar SU SOLUCIÓN con las condiciones dadas. Aleatoriamente se preguntará de manera aleatoria acerca de los desarrollos en la sesión del martes 1 de diciembre. Por lo que una explicación del código y las decisiones tomadas debe tenerse lista.

NOTA IMPORTANTE: NO DUDE EN COMUNICARSE CON NOSOTROS (sc3.operaciones(-@-)uis.edu.co , sc3.soporte(-@-)uis.edu.co con copia a la cuenta del profesor) por email, si tiene problemas de acceso y ejecución relacionadas con la plataforma únicamente. Para preguntas relacionadas con el desarrollo de la entrega o sobre el curso, solamente a la cuenta de email del profesor.

ASIGNACIONES PRIMERA ENTREGA:

Evaluación 2 (25%) C/C++ Procesamiento Memoria Distribuída (Individual):

Fecha Limite de Entrega: Sábado 23 de Enero de 2021 hasta las 23:59 (GMT - 5, Bogotá Time)

Esta evaluación 2. busca como objetivo hacer un seguimiento sobre el uso de memoria distribuida a través de paso de mensajes, usando MPI. Las condiciones de entrega son fundamentalmente las mismas que en la entrega anterior.

- Tenga en cuenta todas las recomendaciones generales de entrega de la Evaluación 1.

- En esta ocasión, se intentará hacer una paralelización con paso de mensajes, usando MPI. Dentro de su repositorio en github, debe crear el repositorio que llamará MPI, en el cual colocará su solución teniendo en cuenta crear un README explicando que contiene allí.

- Importante que en ese repositorio deberán subir los archivos relacionados con la entrega, que básicamente son (5) cinco:

- Nuevo código en MPI (que llamaran mpi_<nombre_codigo_fuente_original>.c (Si el código fuente que recibieron por ejemplo se llama transform.c, el código nuevo que subirán allí se llamara mpi_transform.c). Como es obvio el código fuente que recibirán es en C.

- Archivo sbatch para la corrida en GUANE-1 (OBLIGATORIO). Igual si su código se llama mpi_transform el sbatch que generaran se llamara transform-mpi.sbatch.

- Archivo Readme en el que muestren las opciones de compilación y de corrida (pueden realizar la compilación en gcc o icc). En ese archivo deben colocar como se ejecuta en GUANE-1. (por ejemplo. mpirun -np XXX .... ..... )

- Archivo de salida que llamarán output_<nombre_codigo_mpi>.txt, entonces si su código se llama mpi_transform.c su archivo de salida se llamara output_transform.txt

- Un archivo en el cual mostraran la comparación de tiempos para tres experiencias diferentes, todas hechas en GUANE-1: Tiempo de corrida de la solución en serial (archivo original), tiempo de corrida en tiempo de la solución en OpenMP y el tiempo de corrida de la solución con paso de mensajes en MPI.

- IMPORTANTE: Se deberá correr en mínimo 2 nodos (tenga en cuenta la cantidad de procesos con -np)

- Realicé el punto 4 igualmente de la anterior evaluación 1, en este caso para MPI.

- Tenga en cuenta las condiciones de entrega expresadas anteriormente para la evaluación 1.

Importante: El email con las indicaciones de corrida y demas información debe enviarse desde el viernes 15 de enero de 2021 a cualquier hora, hasta la fecha y hora límite: Sábado 16 de Enero de 2021 hasta las 23:59 (GMT - 5, Bogotá Time)

Es posible que encuentren soluciones de los problemas dados ya implementadas en MPI (de hecho, todos los problemas tienen ya solución paralela con paso de menajes), por lo que pueden usarla como guía (no solo se limiten a copiar y pegar), y por supuesto entender lo que hace ya paralelizado pues al igual que en la primera evaluación, deben enviar SU SOLUCIÓN con las condiciones dadas. Aleatoriamente se preguntará de manera aleatoria acerca de los desarrollos en la sesión del martes siguiente, 20 de enero de 2021. Por lo que una explicación del código y las decisiones tomadas debe tenerse lista.

Evaluación 3 (25%) C/C++ Procesamiento Memoria Híbrida CPU/GPU (Individual):

Desarrollo: Desde el 9 al 12 de febrero de 2021

Esta evaluación es el desarrollo de una actividad de certificación realizada con NVIDIA y se dará las indicaciones posteriormente.

Evaluación 4 (25%) Proyecto Final (TRABAJO COLABORATIVO):

Entrega: 27 de Febrero de 2021 hasta las 23:59 (GMT - 5) / Presentación: 3 de Marzo de 2021 (En el horario de la Clase)

El trabajo final de aplicación busca evaluar las competencias obtenidas en el curso en el desarrollo de una solución de programación paralela desde la concepción misma del tratamiento del problema, hasta la selección del paradigma para la implementación y la implementación misma. Para todas las asignaciones, se tendrá en cuenta lo siguiente:

- Análisis y proposición del algoritmo solución paralela.

- Análisis de los resultados (por ejemplo, solución secuencial vs solución paralela, paradigma/mecanismo de implementación vs otros paradigmas posibles a utilizar, aceleración obtenida)/

- Escalabilidad de la solución y calidad de la misma.

Requisitos de Entrega

1. Debe crear un repositorio con un nombre clave del proyecto asignado dado por ustedes en el GitLab/GitHub anteriormente explicado, asociarlo a los espacios y equipo SC3UIS al igual que con las entregas anteriores y vincularlo a los integrantes del grupo. En el repositorio el archivo README.md debe contener el enunciado del problema dado, en análisis en texto que se hizo para proponer la solución paralela. En el mismo archivo debe explicar como se compila y ejecuta (si es posible ejecutarlo en local o no. Si si es posible, distinguir la compilación/ejecución en local de GUANE-1) Dentro de su repositorio de tener los siguientes archivos (organizados lo mejor posible, puede ser en repositorios): - Archivo con el código Fuente (En C o C++) con el paradigma utilizado (openmp, mpi, cuda u openacc) (No olvidar documentarlo)

- Archivo Sbatch con condiciones de corrida en GUANE-1 (No olvidar documentarlo)

- Archivo de Entrada de Datos

- Archivo de Salida de Datos/Resultados

- Archivo *.pdf con la presentación del proyecto (máximo 12 diapositivas). En estas diapositivas debe estar el análisis precisamente de escalabilidad, aceleración, resultados, recomendaciones, limitaciones, etc (No olvide colocar los nombres de todos los integrantes)

2. Crear el repositorio en GUANE-1 con los archivos anteriores, salvo el archivo *.pdf Grupos de Trabajo y Asignaciones 2-2020

Equipo 1 : "HPC contra Virus"

Un equipo de biólogos esta trabajando con datos obtenidos después de secuenciación en entender mejor el virus del Dengue para proponer identificación, tratamientos eficientes y posibles vacunas, pero es necesario procesar con técnicas de bioinformática los datos obtenidos en tiempo record, de la manera más simple y eficiente posible. Para ello tienen una serie de archivos que requieren tratar y tener en cuenta y recurren a ustedes para tratarlos, buscando obtener la siguiente información:

- ¿Cuál es la secuencia que más se repite en cada uno de los archivos dados de 6 y 9 caracteres? ¿Cuántas veces?

- ¿Cuál es la secuencia que más se repite en todo el conjunto de archivos dados? (Recuerde para 5 y 7 caracteres)

- Dada esa secuencia dada, identifique en que archivos dados se da esas mayores repeticiones.

- ¿Cuales archivos tienen datos inválidos (Caracteres diferentes a ACGTC, pueden ser espacios, signos o las letras en minúscula).

- Hay una sospecha de diseño del virus en alguna (o algunas) de las secuencias dadas. Si es cierto, debe aparecer la secuencia GATTACCA. Su solución debe igualmente buscar e identificar los archivos en los cuales aparece dicha secuencia y cuantas veces (en particular y en general).

Si desea aprender mas sobre secuenciación y formatos de referencia, puede ver el enlace: https://bioinformatics-core-shared-training.github.io/intro-to-IGV/fileFormats.pdf

Nota, los datos son basados en secuencias reales, pero completamente sintéticos y modificados para los fines del proyecto final del curso. (Cortesia: https://www.ncbi.nlm.nih.gov/) Estos se enviarán por correo electrónico directamente.

Integrantes del equipo:

2163024 - BUITRAGO MEDINA JONATHAN EDUARDO

2160044 - CHACON SUAREZ JAVIER ALEXI

2162130 - MANTILLA ROMERO LAURA MARCELA

2161889 - PINTO DIAZ DUVAN FERNANDO

2160066 - VEGA ARRIETA JOSE SAUL

Equipo 2 : "Simulación y Altas Prestaciones"

2151824 - CASTELLANOS CONGUTA YANN KARLO

2142665 - DUARTE DELGADO MIGUEL ANGEL

2131799 - NAVARRO HERRERA HORDAN ANDRES

2122079 - ROJAS CHACON DAMAR NICOLAS

2161698 - VILLAMIZAR CORREA DIEGO ARMANDO

Equipo 3: "Economía del Pico y Cédula y Paralelísmo"

Las medidas de aislamiento y restricción de movilidad se han debido endurecer en los siguientes seis meses, debido a los problemas asociados con la deficiente atención médica, la vulnerabilidad de la población en términos sanitarios y aspectos culturales. Teniendo en cuenta que se tomó la decision de implementar un pico y cédula estricto observando el último dígito de la cédula (dia par = cédula que termina en cero y par, dia impar = cédula que termina en número impar), y utilizando un archivo que contiene los números de cédula para una población especifica obtenido del último censo electoral de 2019, responda las siguientes preguntas:

- ¿ Cuántas personas con cédula par e impar saldrían en cada dia correspondiente para su pico y cédula de los meses de febrero, marzo y abril? (Tenga en cuenta que cada mes tiene dias diferentes y asignaciones de fecha por dia diferentes).

- ¿Cuántas veces las personas con pico y cédula par, pueden salir sin restricción los dias sábado?.

- ¿Cuántas personas con pico y cédula impar pueden salir sin restricción los dias domingo?.

- Las personas con cédula de identificación de 10 dígitos son personas de 18 a 20 años. ¿Cuántas son y cómo es la distribución de salida por mes los fines de semana?

- Proporcione datos para dar información de análisis a los tomadores de decisiones políticos y ver si es proporcional y justa la medida del pico y cédula para esa población, observando números pares e impares, tomando, la población en general (cantidad total de habitantes), personas de menos de 20 años (cédulas con diez cifras), personas de mayores de 60 años (Entre 6 y 7 cifras) y extranjeros (cédulas con menos de 7 cifras).

Su solución debe permitir obtene

Nota, los datos son basados de datos reales obtenidos por la Universidad Popular del Cesar de los registros de la Registraduría Nacional de Colombia (https://www.registraduria.gov.co/) y mantienen su anonimato. Estos se enviarán directamente al correo.

2111127 - CASTILLO JAIMES JORGE SAUL

2130535 - GOMEZ ESTUPIÑAN ANGEL FABIAN

2130478 - PEREA PEREZ JORGE LUIS

2170107 - TOLOSA VILLAMIZAR JULIAN FELIPE

Grupos de Trabajo y Asignaciones 2-2018

| Grupo | Participantes | Descripción del Trabajo |

|---|---|---|

| 1 | 2103657 - ALVAREZ TEJADA GABRIEL DE JESUS

2122485 - HERNANDEZ PABON JORGE ANDRES |

Problema de N - Cuerpos (https://es.wikipedia.org/wiki/Problema_de_los_n_cuerpos)

El problema de N-Cuerpos es bien conocido y básicamente lo que trata es determinar los movimientos individuales de un grupo de partículas materiales siguiendo física newtoniana. Diferentes propuestas para realizar la simulación de n-cuerpos se encuentran implementadas, por ejemplo la que se encuentra en: http://www.new-npac.org/projects/cdroms/cewes-1999-06-vol2/cps615course/examples96/nbody-stuff/nbody.c La asignación de este problema es realizar un código paralelo que permita la interacción de mínimo 1000 (mil) partículas en tres dimensiones. No se recomienda el uso de interpretadores. Bonus en nota: Si presenta gráficamente la simulación de los cuerpos. |

| 2 | 2140180 - LEON PEREZ FABIAN ANDRES

2151196 - LOPEZ DURAN JHON EDINSON |

Ecuación de Calor (https://es.wikipedia.org/wiki/Ecuaci%C3%B3n_del_calor)

La ecuación del calor es una importante ecuación diferencial en derivadas parciales del tipo parabólica que describe la distribución del calor (o variaciones de la temperatura) en una región a lo largo del transcurso del tiempo. Dependiendo de las dimensiones a trabajar (siendo la más conocida en 2D) existen diferentes implementaciones como la que se encuentra en: https://people.sc.fsu.edu/~jburkardt/c_src/heated_plate/heated_plate.c El objetivo que se busca en esta asignación es realizar un código paralelo que permita el análisis de la ecuación de calor de manera tridimensional en un cubo. No se recomienda el uso de interpretadores. Bonus de nota: Si se presenta gráficamente la simulación correspondiente a la solución. |

| 3 | 2143696 - MANTILLA LOPEZ JUAN DAVID

2141354 - OÑATE LIZARAZO LEYSTON ALEXANDER |

Ecuación de Onda (https://es.wikipedia.org/wiki/Ecuaci%C3%B3n_de_onda)

La ecuación de onda es una importante ecuación diferencial en derivadas parciales lineal de segundo orden que describe la propagación de una variedad de ondas, como las ondas sonoras, las ondas de luz y las ondas en el agua. Computacionalmente se encuentran soluciones para tratar la sumación y propagación, siendo muy conocidas aquellas que han sido implementadas por supuesto en una o dos dimensiones ( http://www.labbookpages.co.uk/audio/beamforming/waveSum.html o https://computing.llnl.gov/tutorials/parallel_comp/#ExamplesWave) La asignación a este trabajo es proponer una solución paralela para la ecuación de onda en 2D. No se recomienda el uso de interpretadores. Bonus de nota: Si se presenta gráficamente la simulación correspondiente a la solución dada. |

Bibliografía y Fuentes de Información

- Elements of Parallel Computing, Eric Aubanel (Chapman & Hall/CRC)

- Essentials of Computer Architecture, D. Comer (CRC Press)

- High Performance Embedded Computing: Applications in Cyber-Physical systems and Mobile Computing, M. Wolf (Morgan Kaufmann)

- The Fourth Paradigm: Data-Intensive Scientific Discovery

- Designing and Building Parallel Programs, by Ian Foster

- Patterns for Parallel Programming, by Timothy G. Mattson, Beverly A. Sanders and Berna L. Massingill. Software Patterns Series, Addison Wesley Ed., USA. 2009

- Patterns for Parallel Software Design, Jorge Luis Ortega-Arjona (Wiley)

- Structured Parallel Programming: Patterns for Efficient Computation, M. McCool, A. D. Robison and J. Reinders (Morgan Kaufmann)

- The Art of Concurrency “A thread Monkey’s Guide to Writing Parallel Applications”, by Clay Breshears (Ed. O Reilly, 2009)

- Parallel Scientific Computing in C++ and MPI « A Seamless Approach to Parallel Algorithms and Their Implementation », Karniadakis and Kirby II (Cambridge Press)

- Parallel And Distributed Computation Numerical Methods, D. P. Bertsekas and J. N. Tsitsiklis (Prentice Hall)

- An Introduction to High Performance Scientific Computing, Scientific and Engineering Computation Series, Ll. D. Fosdick, E. R. Jessup, C. J. C. Schauble and G. Dmik (MIT Press)

- The Algorithms Design Manual, S. S. Skiena ( Springer)

- Algorithms Sequential and Parallel « A Unified Approach » Miller and Boxer (Computing Engineering Series)

- Parallel Algorithms, Cassanova, Legrand and Robert (Chapman and Hall/CRC)

- Fundamentals of Multicore Software Development, Ed. Victor Pankratius, Ali-Reza Adl-Tabatabai and Walter Tichy (CRC Press)

- Introduction to HPC with MPI for Data Science, Frank Nielsen (Springer)

- Programming Massively Parallel Processors « A Hands-on Approach » , Kirk and Hwu (Nvidia/Morgan Kaufmann)

- CUDA Application Design and Development, Rob Farber (Nvidia/Morgan Kaufmann)

- Introduction to High Performance Computing for Scientists and Engineers, Hager and Wellein (Chapman and Hall/CRC)

- Sourcebook of Parallel Computing , Dongarra, Foster, Fox, Groop, Kennedy, Torczon and White (Morgan Kaufmann)

- CUDA Programming: A Developer's Guide to Parallel Computing with GPUs, S. Cook (Morgan Kaufmann)

- The CUDA Handbook: A Comprehensive Guide to GPU Programming, N. Wilt (Addison-Wesley)

- CUDA by Example « An Introduction to General-Purpose GPU Programming » Sanders and Kandrot (Nvidia/Addison Wesley)

- CUDA Fortran for Scientists and Engineers: Best Practices for Efficient CUDA Fortran Programming, G. Ruetsch and M. Fatica (Morgan Kaufmann/PGI/Nvidia)

- HPC@Green IT: Green High Performance Computing Methods, R. Gruber and V. Keller (Springer)

- OpenACC for Programmers: Concepts and Strategies, S. Chandraserkaran and G. Juckeland (Addison-Wesley)

- OpenACC: Parallel Programming with OpenACC, Edited by Rob Farber (Morgan Kaufmann)

- High Performance Parallelism Pearls: Multicore and Many-core Programming Approaches, J. Reinders and J. Jeffers (Morgan Kaufmann)

- OpenMP

- OpenACC

- NVIDIA

- SC3

- RICAP

- Computing.llnl.gov

- SC-Camp

PRESENTACIONES DEL CURSO

- An Introduction to HPC and Advanced Computing

- Introducción Linux

- Simple Linux Utility for Resource Management

- Concurrency and Paralellism

- Debugging

- Shared Memory Programming with OpenMP (In Spanish/En Español)

- Distributed Memory Exploitation with MPI: An Introduction

- Hybrid/Heterogeneous Computing

CONSULTA A ESTUDIANTES

Debido a las circunstancias actuales, las consultas pueden planificarse de manera asincrónica via correo electrónico, enviando un correo al profesor de la asignatura o al auxiliar de postgrado. En la práctica, via el foro creado para tal fin o durante las sesiones de las mismas.